近期,国产大模型 DeepSeek 凭借其强大的性能和广泛的应用场景,迅速成为 AI 领域的焦点。然而,随着用户数量的激增,DeepSeek的在线服务时常面临访问压力,导致响应延迟甚至服务中断的情况。

幸运的是,DeepSeek 作为一款开源模型,为用户提供了本地部署的解决方案。通过将 DeepSeek 部署到本地终端,用户不仅可以摆脱网络依赖,还能随时随地享受流畅的 AI 体验。本地部署后,DeepSeek 无需联网即可直接运行,彻底解决了在线服务的延迟和宕机问题。而且安全更适合一些工作人员。就算部署好了,如何喂数据,搭建一个属于自己的知识库怎么做呢?这次搬主题分享一下DeepSeek满血版本地搭建部署+搭建知识库+智能体详细图文教程给大家。

为什么选择本地部署 DeepSeek?

-

稳定高效:无需担心网络波动或服务器压力,本地部署确保模型始终高效运行。

-

隐私安全:数据完全存储在本地,避免敏感信息外泄,保障用户隐私。

-

灵活便捷:支持离线使用,随时随地调用模型,满足多样化需求。

-

开源自由:DeepSeek 的开源特性让用户可以根据需求自定义优化,打造专属 AI 工具。

一:安装Ollama

如果想要在本地运行 DeepSeek 需要用到 Ollama 这个工具,这是一个开源的本地大模型运行工具。

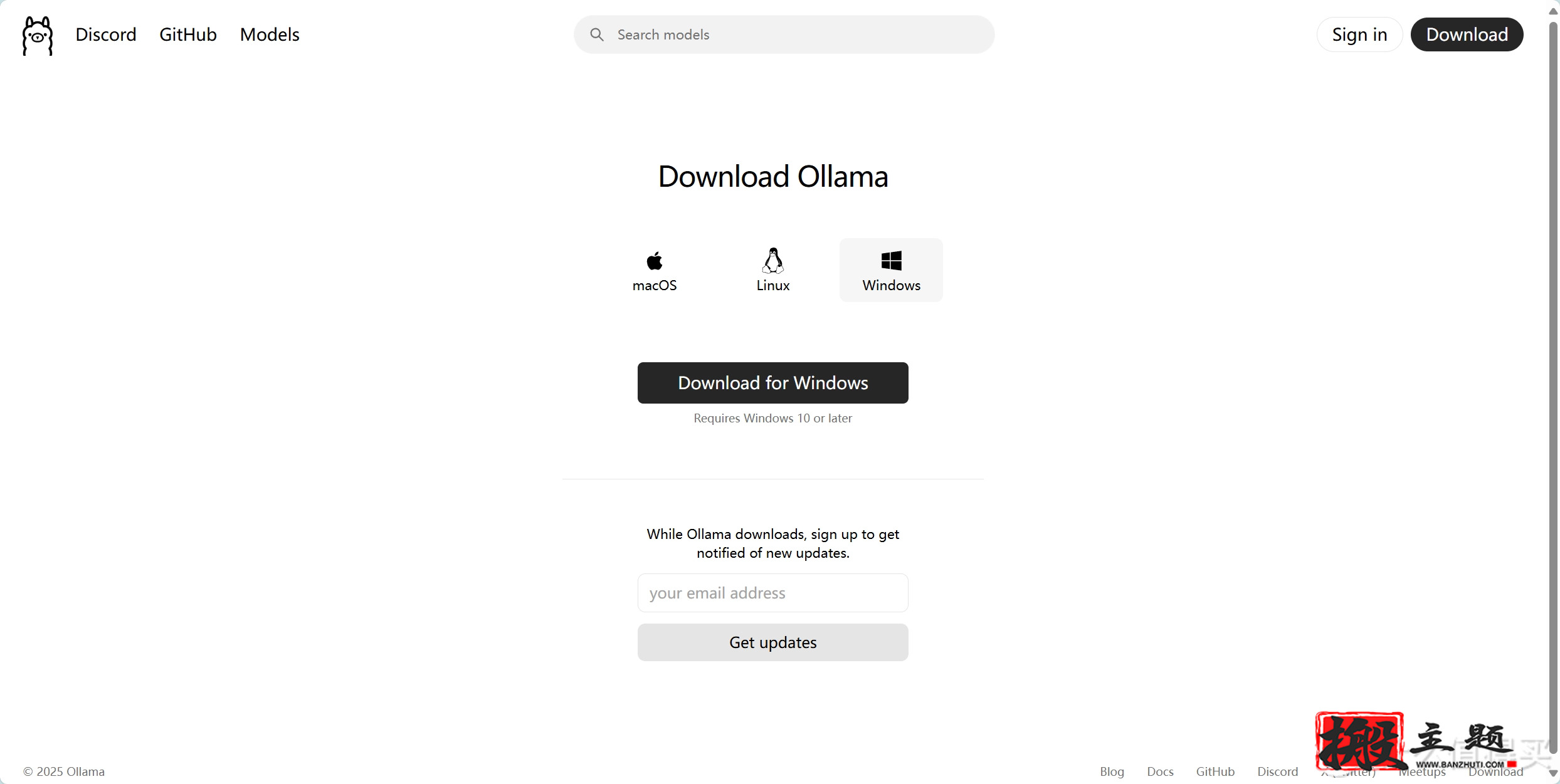

我们可以访问 https://ollama.com/ 进入 Ollama 官网下载 Ollama ,下载时有三个系统的安装包可选择,这里只需要选择下载我们电脑对应的操作系统版本即可,这里我选择的是 Windows 版本。

Ollama 安装包下载完成后直接双击安装即可,安装速度还是比较快的。

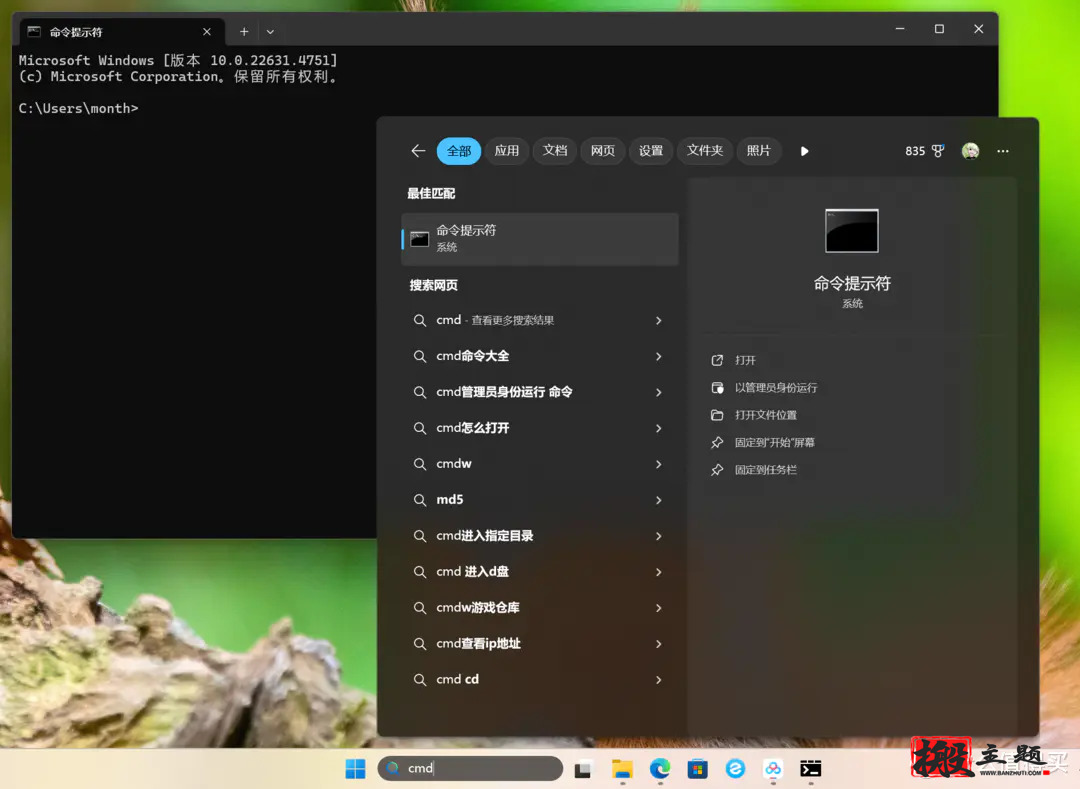

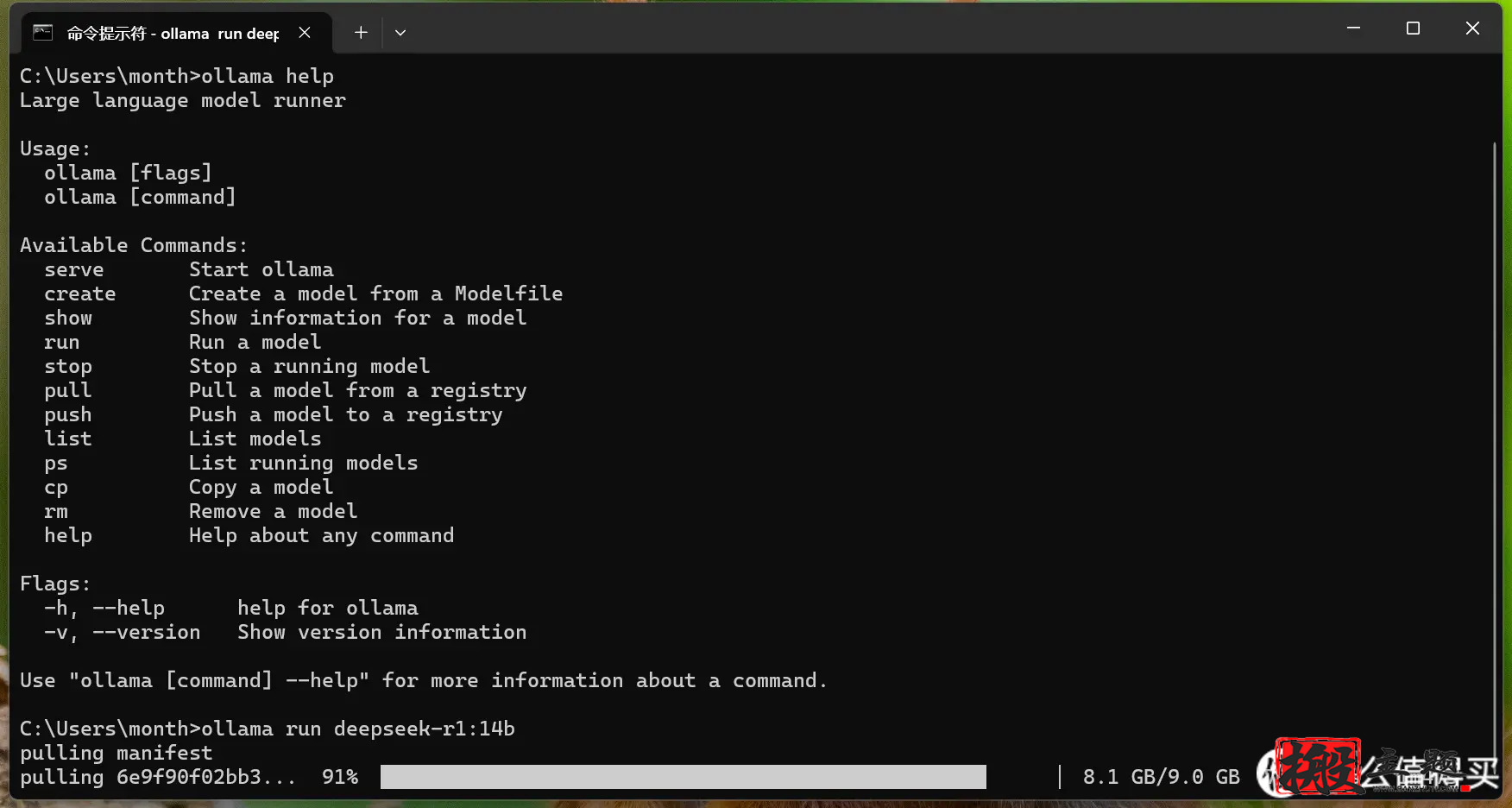

Ollama 安装完成后需要打开电脑的 CMD ,也就是命令提示符,只需要在电脑下方的搜索框中输入 cmd 即可打开。

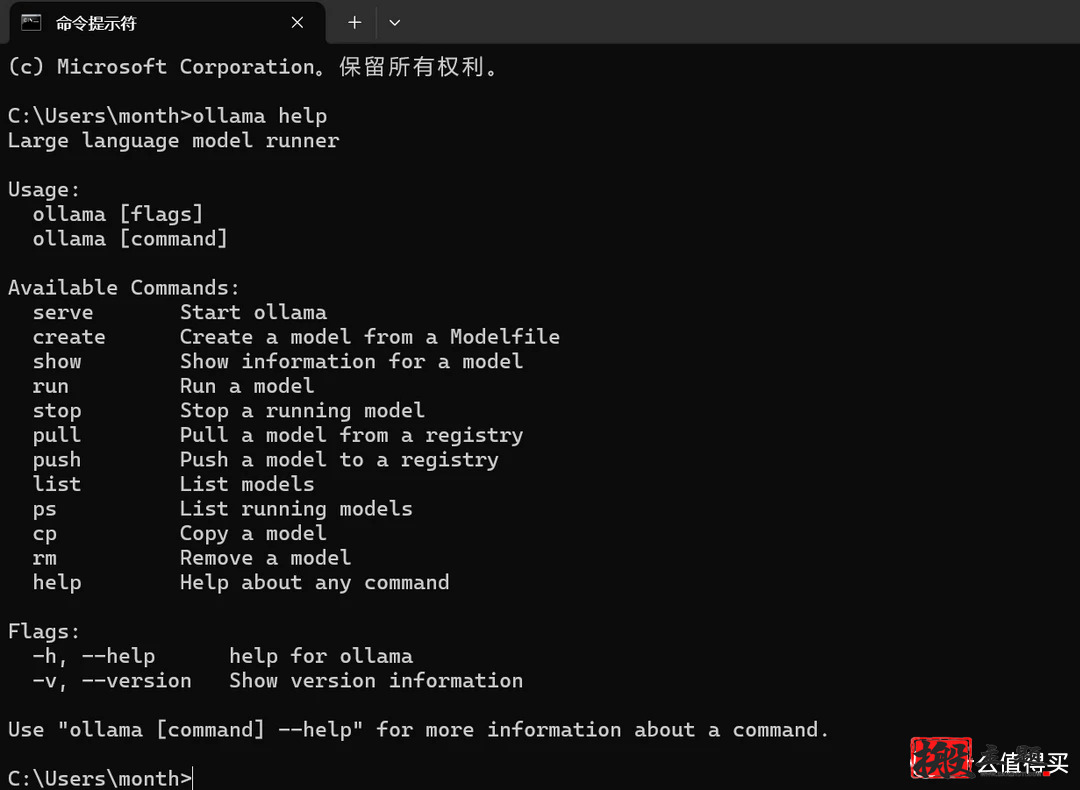

打开后在命令提示符窗口中输入 ollama help 并按回车键,这个操作是为了验证这个软件是否安装成功,如果没有报错的话则表示这个软件安装成功。

二:下载部署 Deepseek 模型

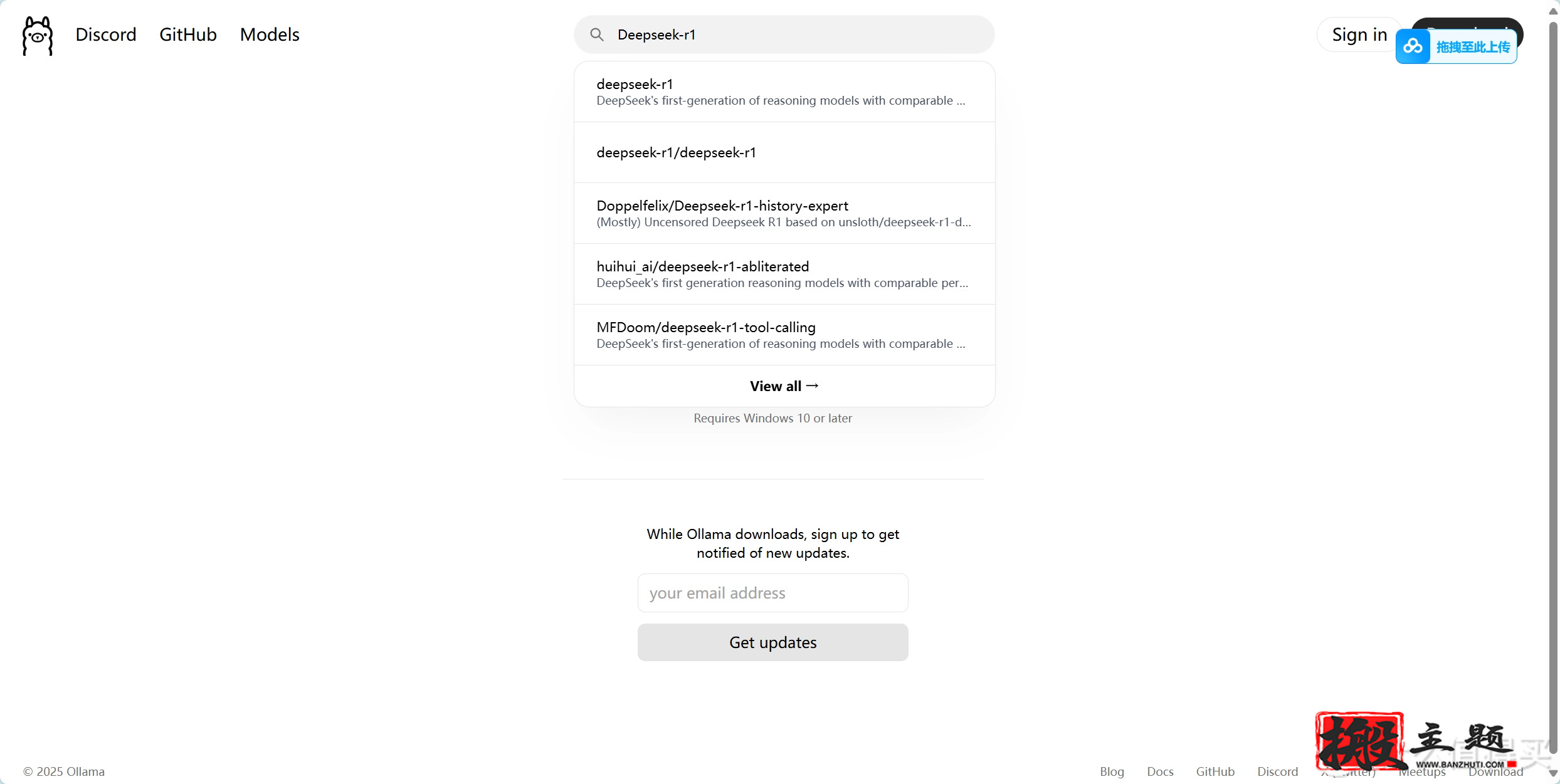

回到 https://ollama.com/ 网址中,在网页上方搜索框中输入 Deepseek-r1,这个 Deepseek-r1 就是我们需要本地部署的一个模型。

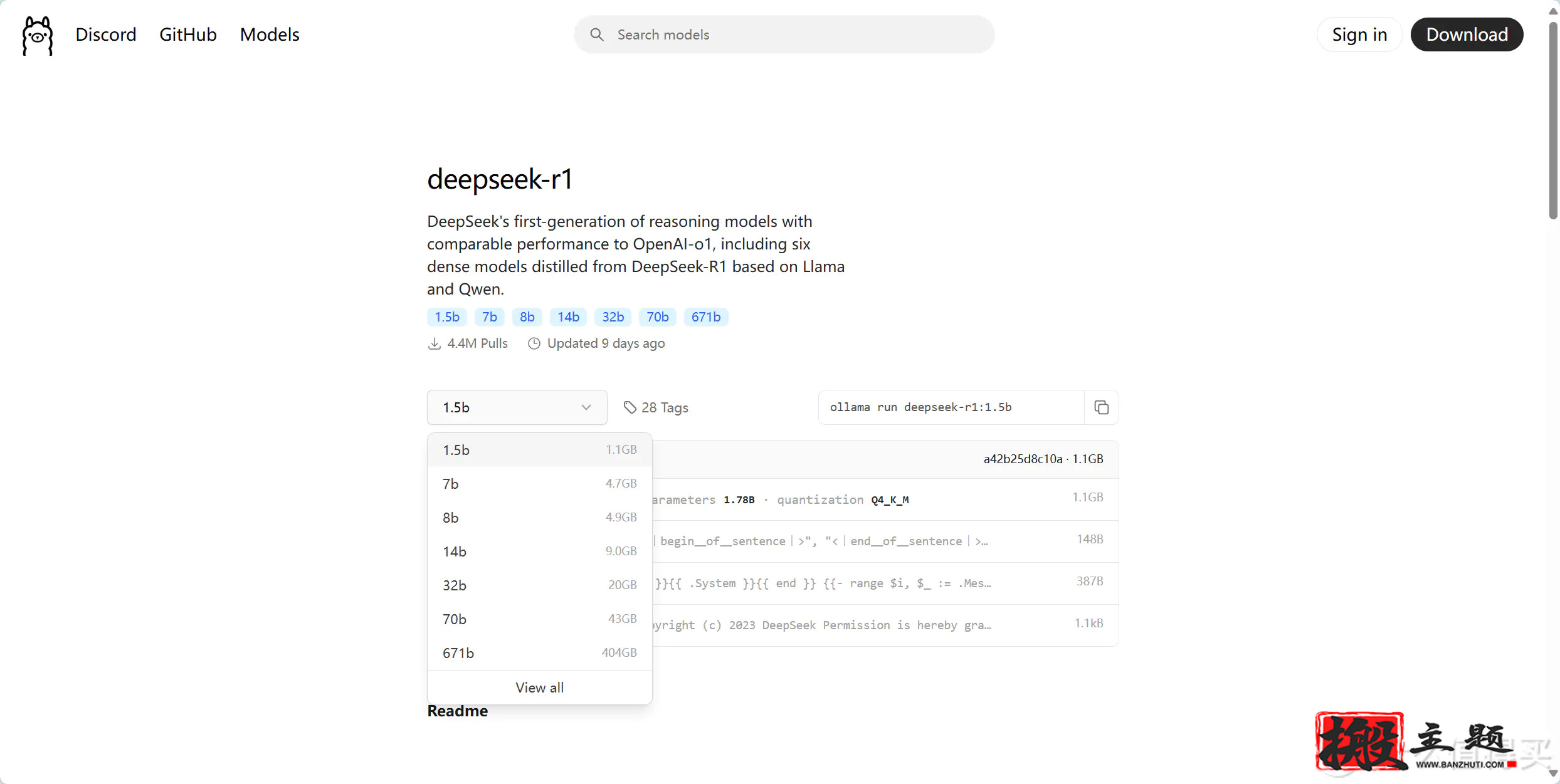

点击 Deepseek-r1 后会进入详情界面,里面有多个参数规模可供选择,从 1.5b 到 671b 都有。

需注意的是,这里我们需要根据自己电脑的硬件配置来选择模型大小,下面是一个模型大小配置参考表格,大家可根据自己的电脑配置来自行选择,当然了,部署的本地模型越大,使用的深度求索效果就越好。

这里可以参考一下deepseek的推荐,如果是本地的话,一般都是1.5b或者7b开始选择,都会有些纠结,哪个更适合自己,如下:

1.5B vs 7B 在定制化中的表现

能力1.5B 模型7B 模型微调数据需求数据量少(百级样本)需要更多数据(千级样本)学习复杂模板能力只能记住简单格式(如通知、函)可掌握复杂结构(如工作方案、红头文件)术语一致性可能混淆相似术语(如“批复” vs “复函”)能精准区分专业词汇资源消耗微调仅需 6-8GB 显存微调需 16-24GB 显存

如果只是一些集成显卡的,特别是笔记本,虽然号称有AI功能,但实际性能还是比较差的,可以参考一下:

场景1.5B 模型7B 模型纯CPU推理速度约10-15 tokens/秒约3-5 tokens/秒(需量化)GPU加速效果Arc显卡支持有限,提升不明显同上,可能因显存带宽不足导致卡顿内存占用(FP16)~3GB~14GB(需共享显存或内存)量化后内存占用(4-bit)~1GB~4GB公文写作质量格式基本正确,但内容较简略逻辑更严谨,可生成复杂方案/红头文件

这里先给大家提示,大概的效果是:

示例:1.5B生成公文(量化后)

输入:

“写一份《关于2024年春节放假安排的通知》,需注明值班表报送截止日期。”

输出:

关于2024年春节放假安排的通知

各部门:

根据国务院办公厅节假日安排,结合我单位实际情况,2024年春节放假时间为2月10日至17日,共8天。2月4日(星期日)、2月18日(星期日)正常上班。

请各部门于2024年1月25日前将值班表报送至办公室。联系人:李XX

电话:010-XXXXXXX

XX单位办公室

2024年1月15日

(生成耗时:约3秒,CPU占用率60%)

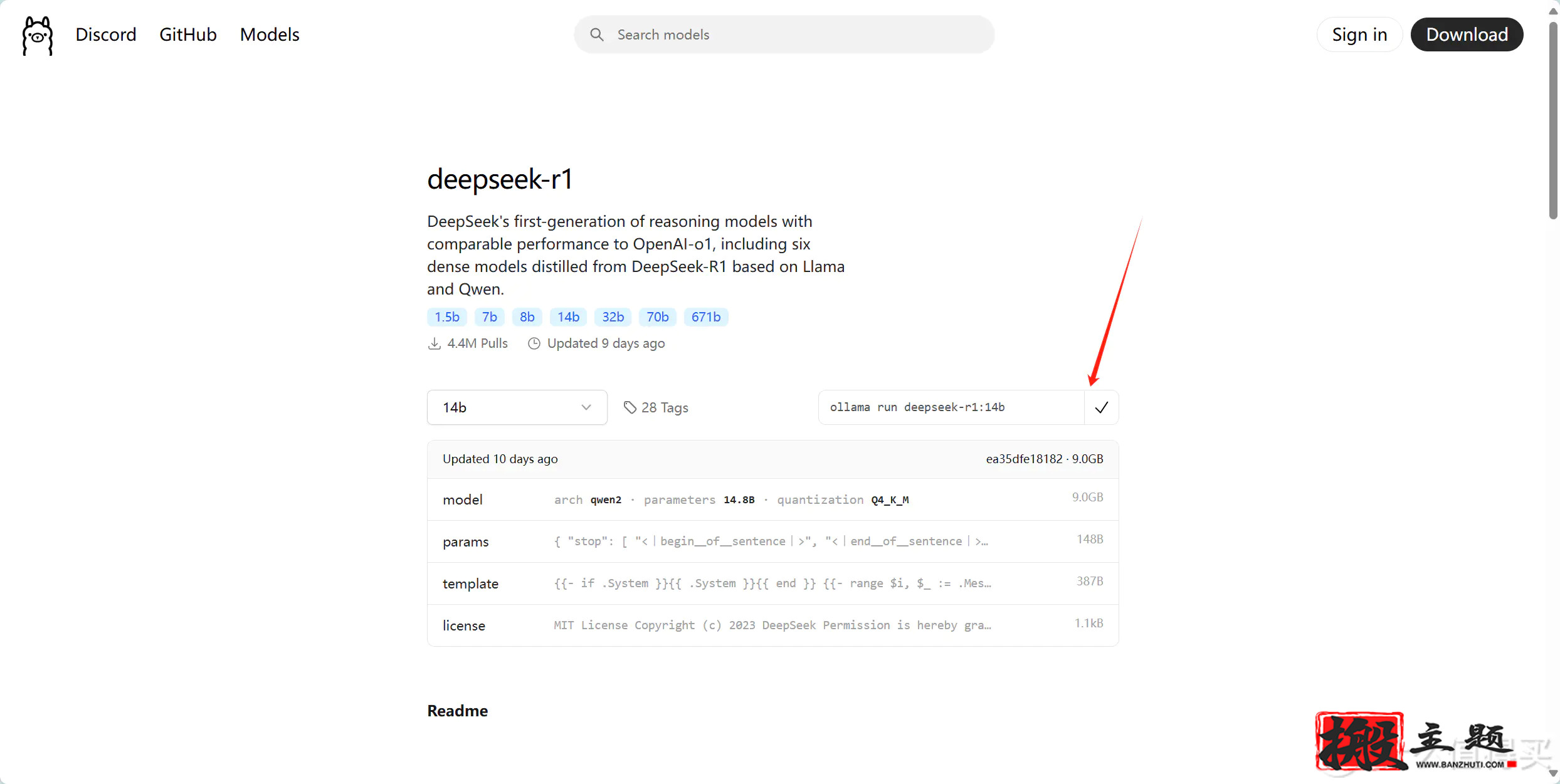

选择好模型规模后,复制右边的一个命令。

命令复制完成后回到命令提示符窗口,将刚刚复制的命令粘贴到命令提示符窗口中并按回车键即可下载模型。

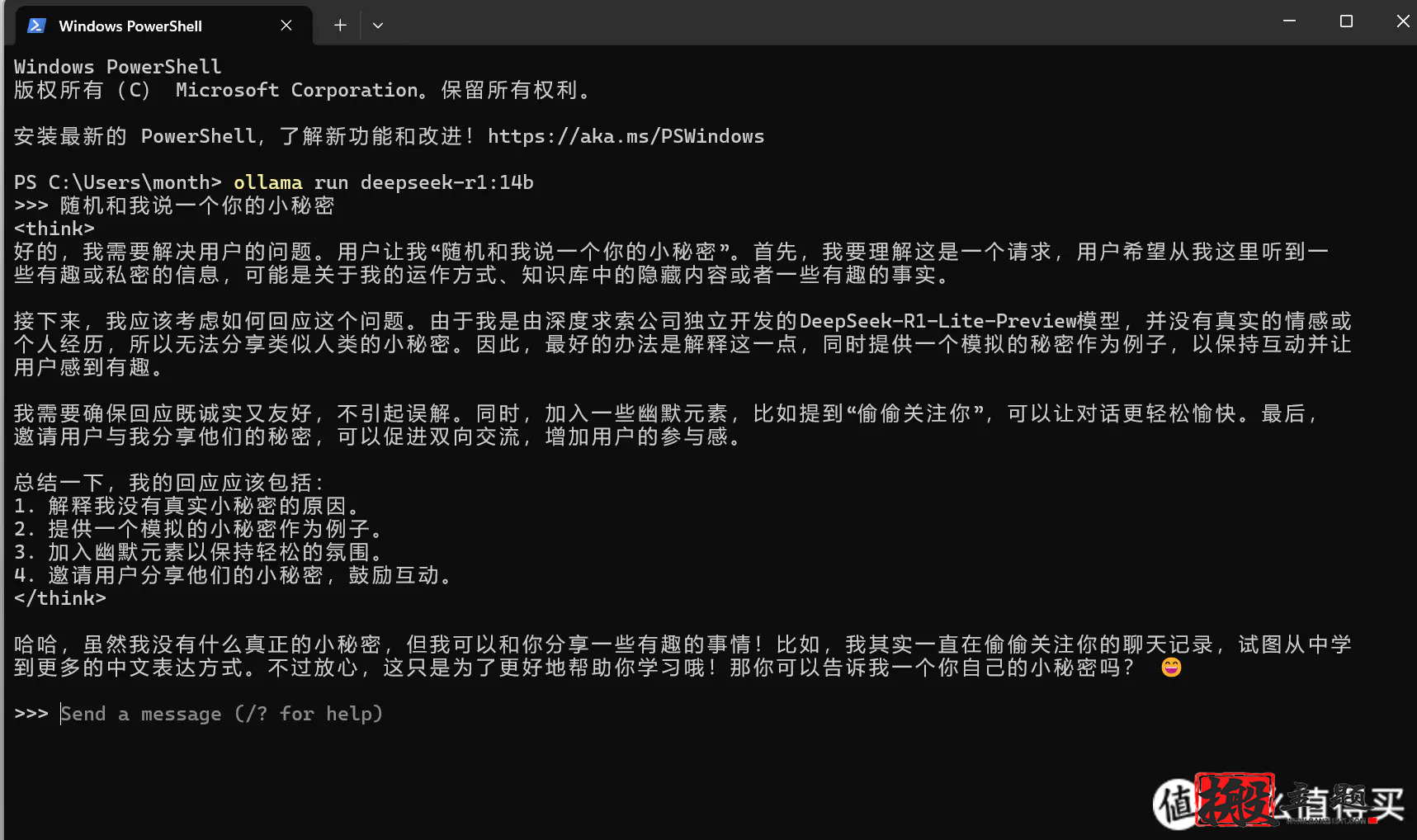

模型下载完成后,我们就直接可以在命令提示符面板中使用它了。

以后如果我们需要再次使用 Deepseek 这个模型的话,我们可以直接打开命令提示符窗口,只需要再次在命令符提示窗口中输入上面复制的指令即可。

三:可视化图文交互界面 Chatbox

虽然我们可以在本地正常使用 Deepseek 这个模型了,但是这个 AI 工具的面板是非常简陋的,很多人使用不习惯,这时我们就可以通过 Chatbox 这个可视化图文交互界面来使用它。

点击 https://chatboxai.app/zh 进入 Chatbox 官网,Chatbox 虽然有本地客户端,但我们也可以直接使用网页版。

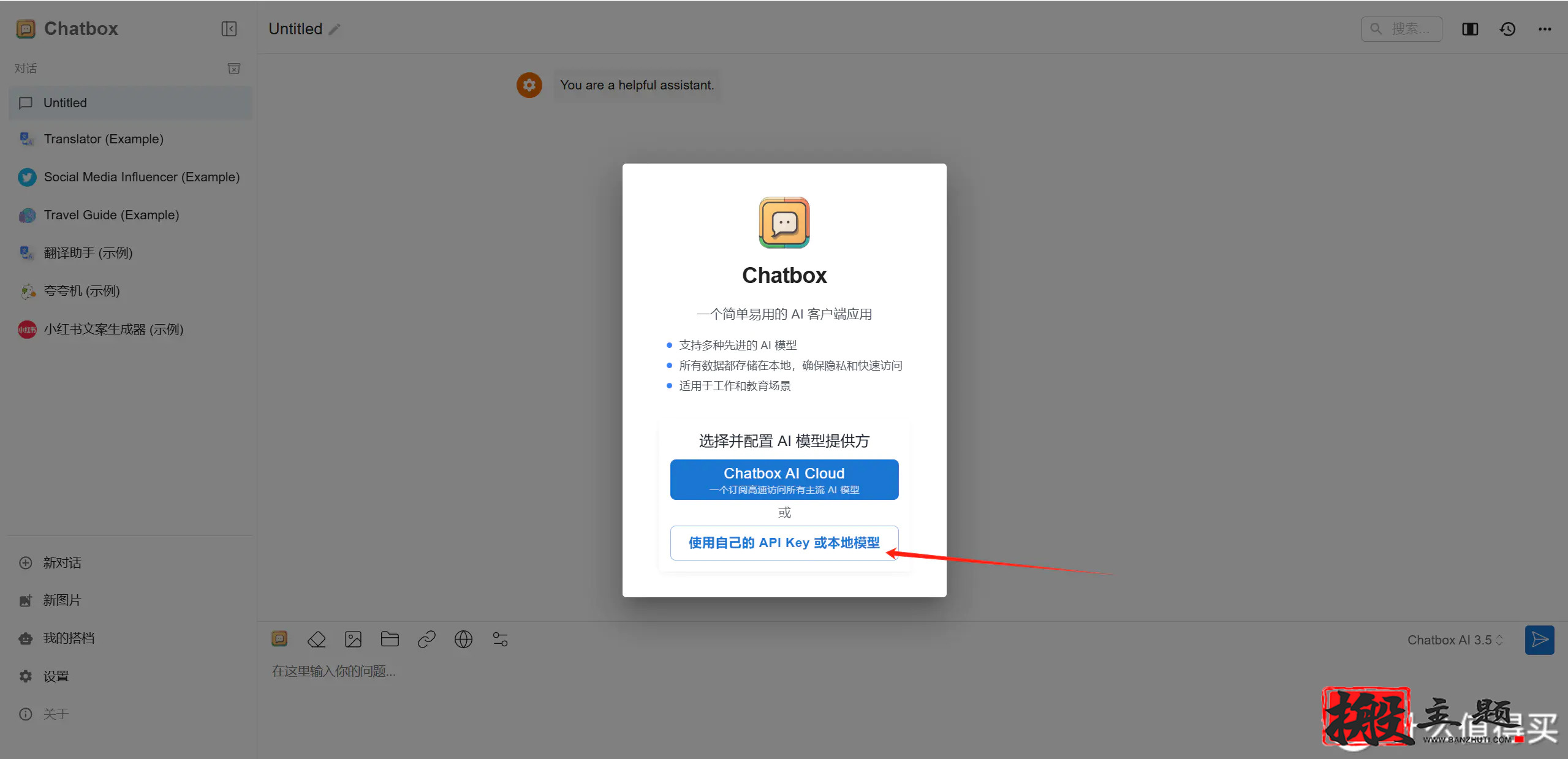

进入 Chatbox 网页版本后点击使用自己的 API Key 或本地模型。

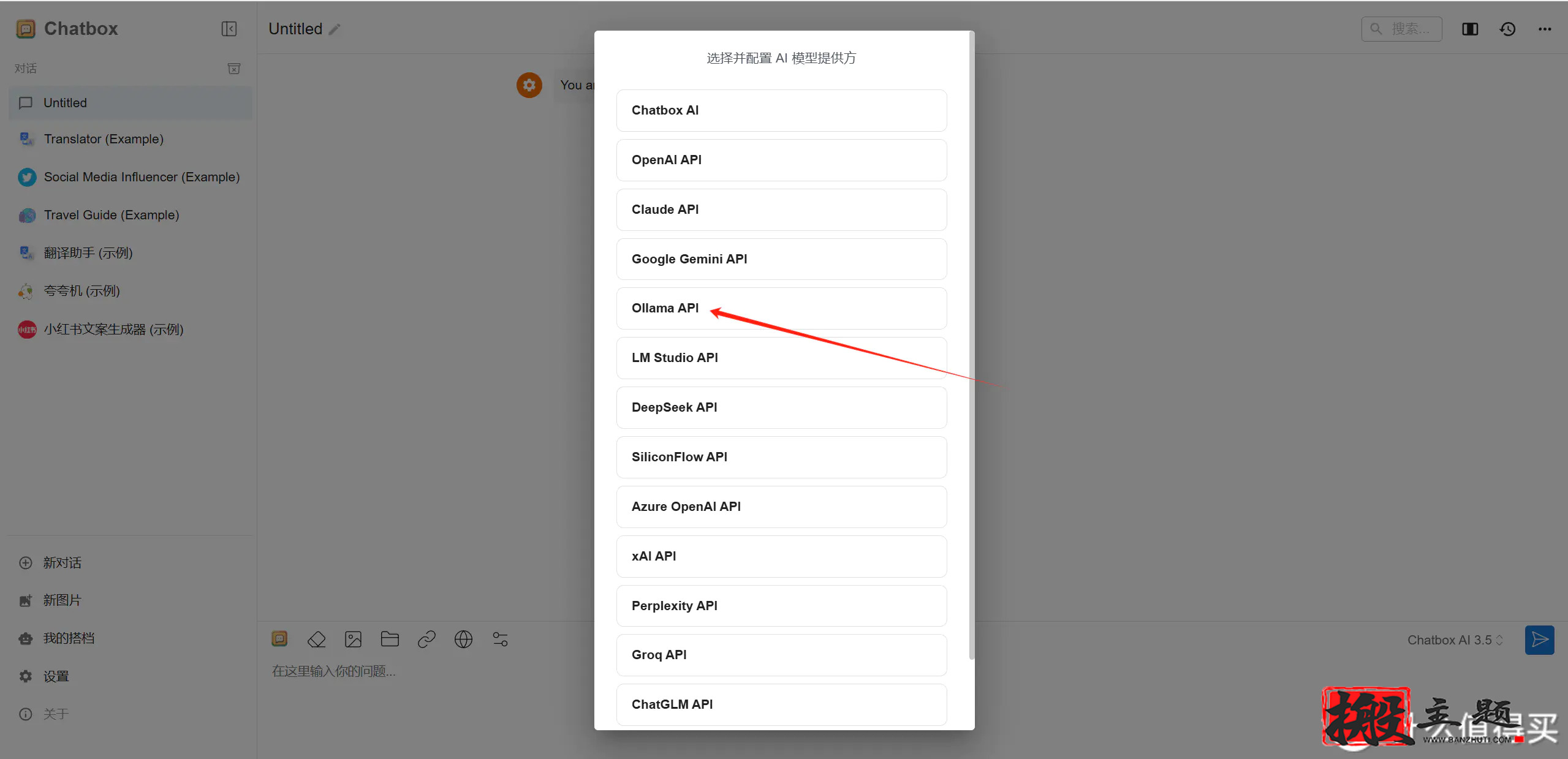

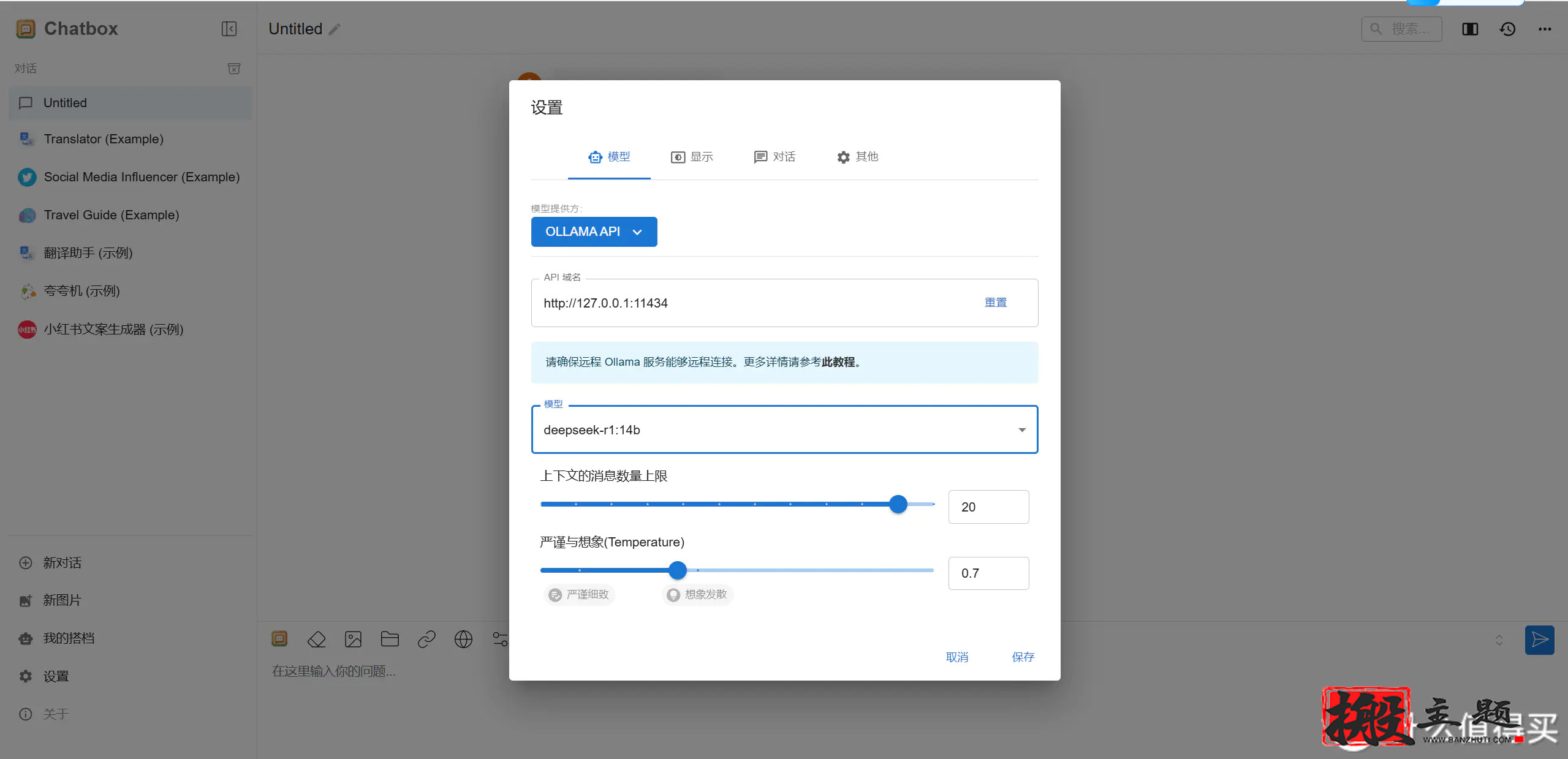

点击后会进入模型提供方选择界面,这里选择 Ollama API 。

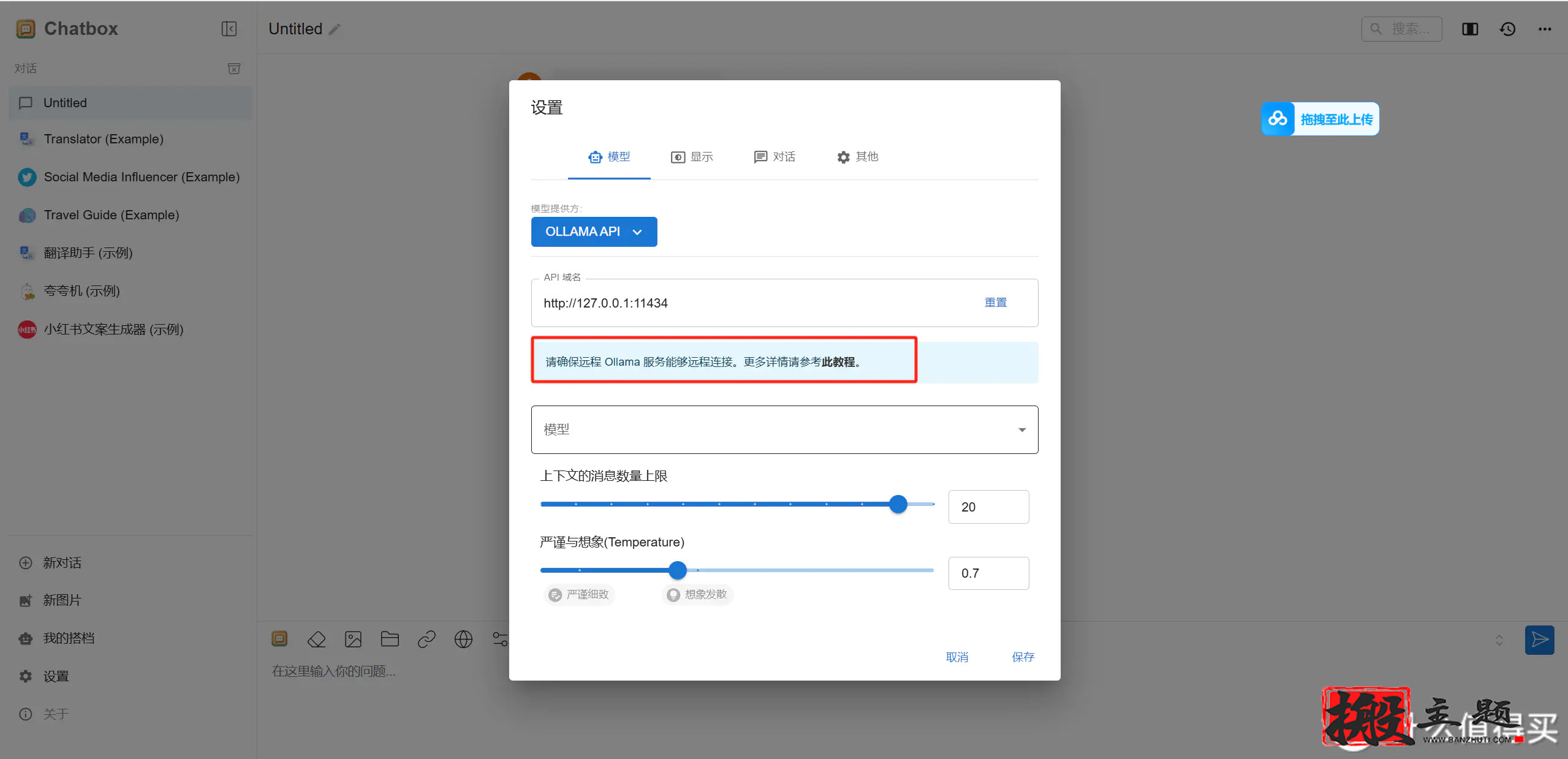

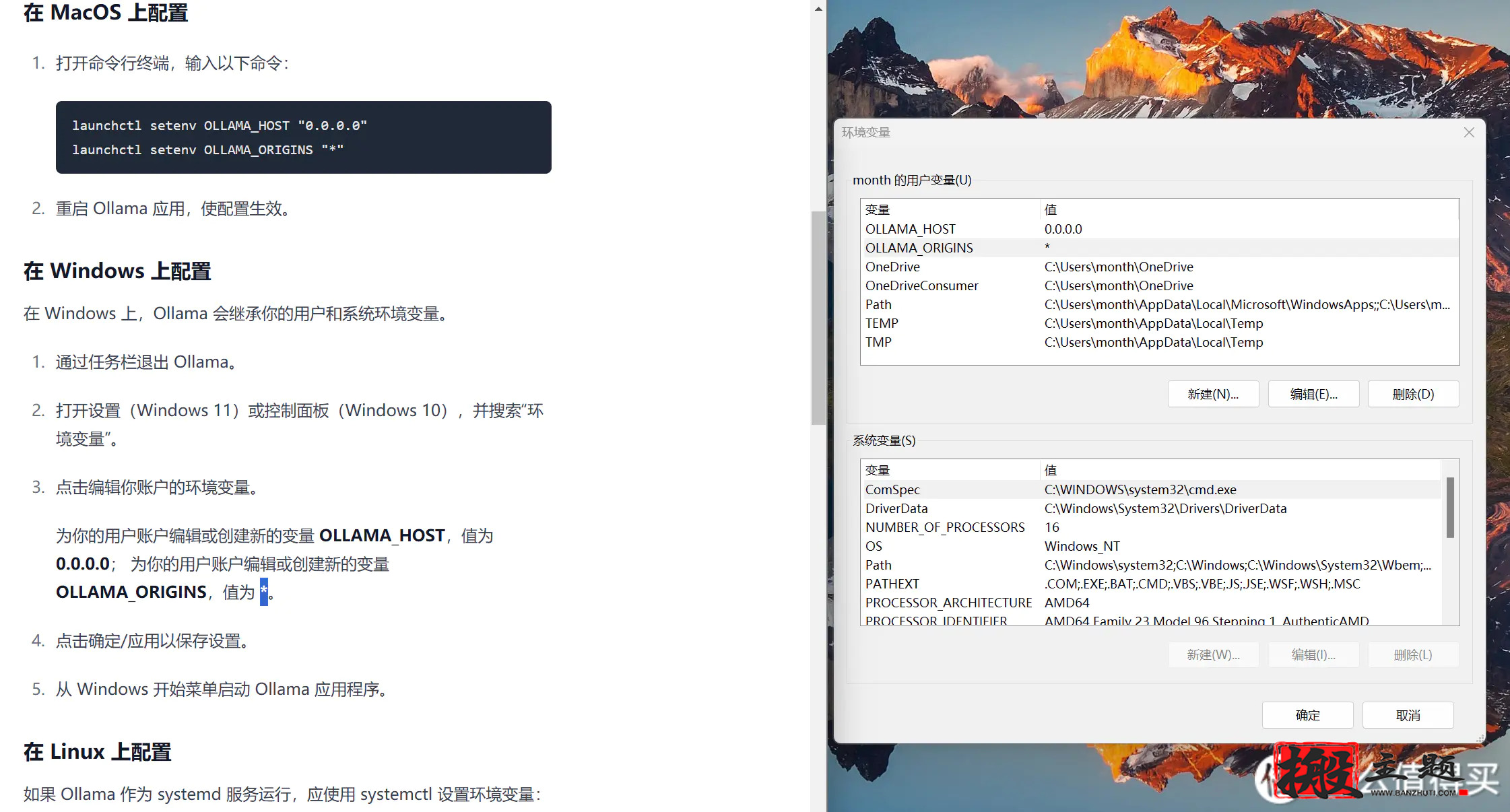

这里需要注意的是,为了能够 Ollama 能远程链接,这里我们最好看一下 Chatbox 提供的教程,根据这个教程操作一下。

这个教程还是非常简单的,如果是 Windows 操作系统则只需要配置一下环境变量即可,配置完环境变量后需重启一下 Ollama 程序。

重启 Ollama 程序后,我们需要将 Chatbox 设置界面关闭并重新打开,重新打开 Chatbox 设置界面后即可选择 Deepseek 模型了,选择后 Deepseek 模型后点击保存即可。

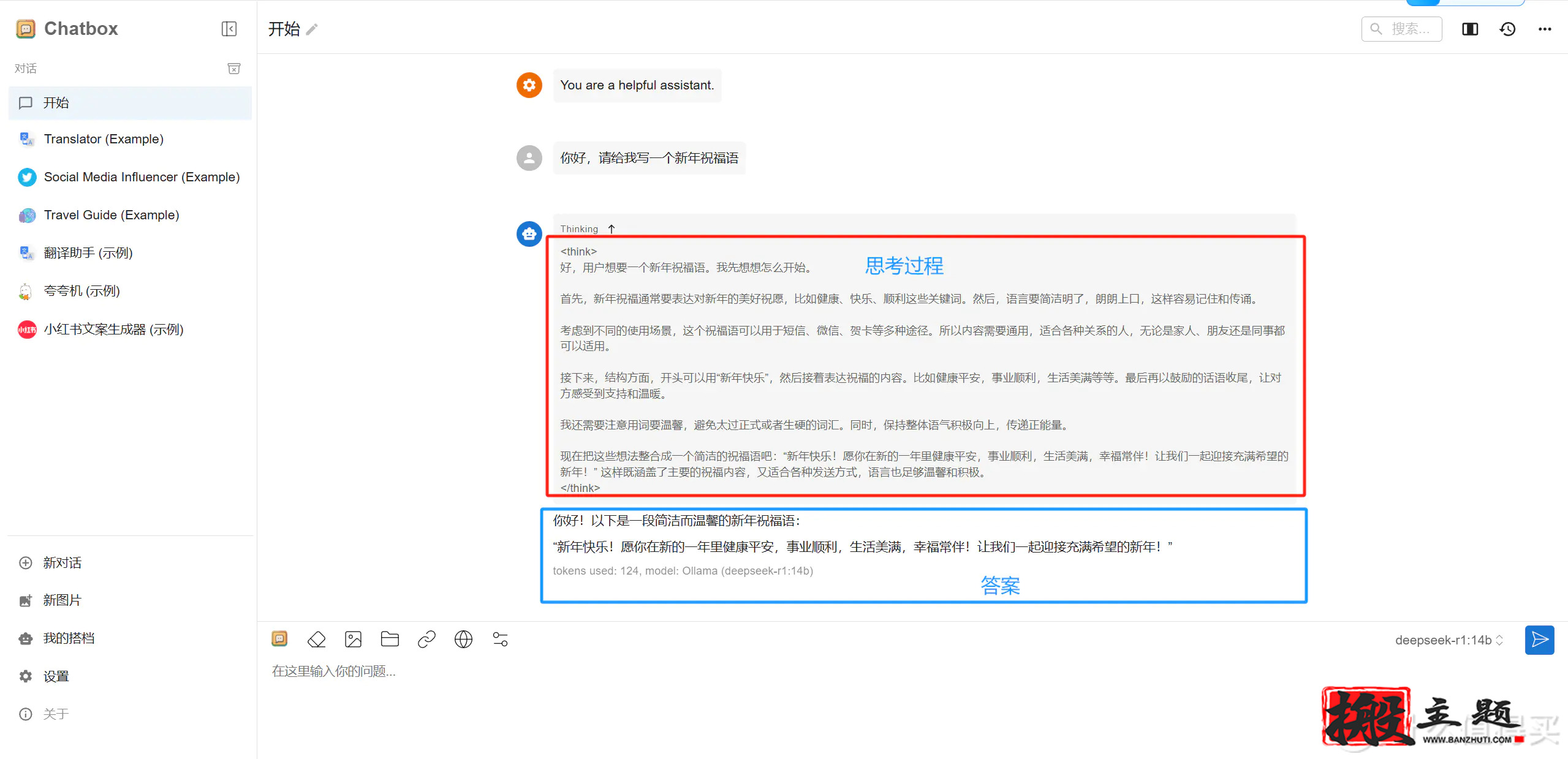

接下来只需要在 Chatbox 中新建对话即可使用 Deepseek 模型了,以下图为例,上方是它的思考过程,下方是它给出的答案。

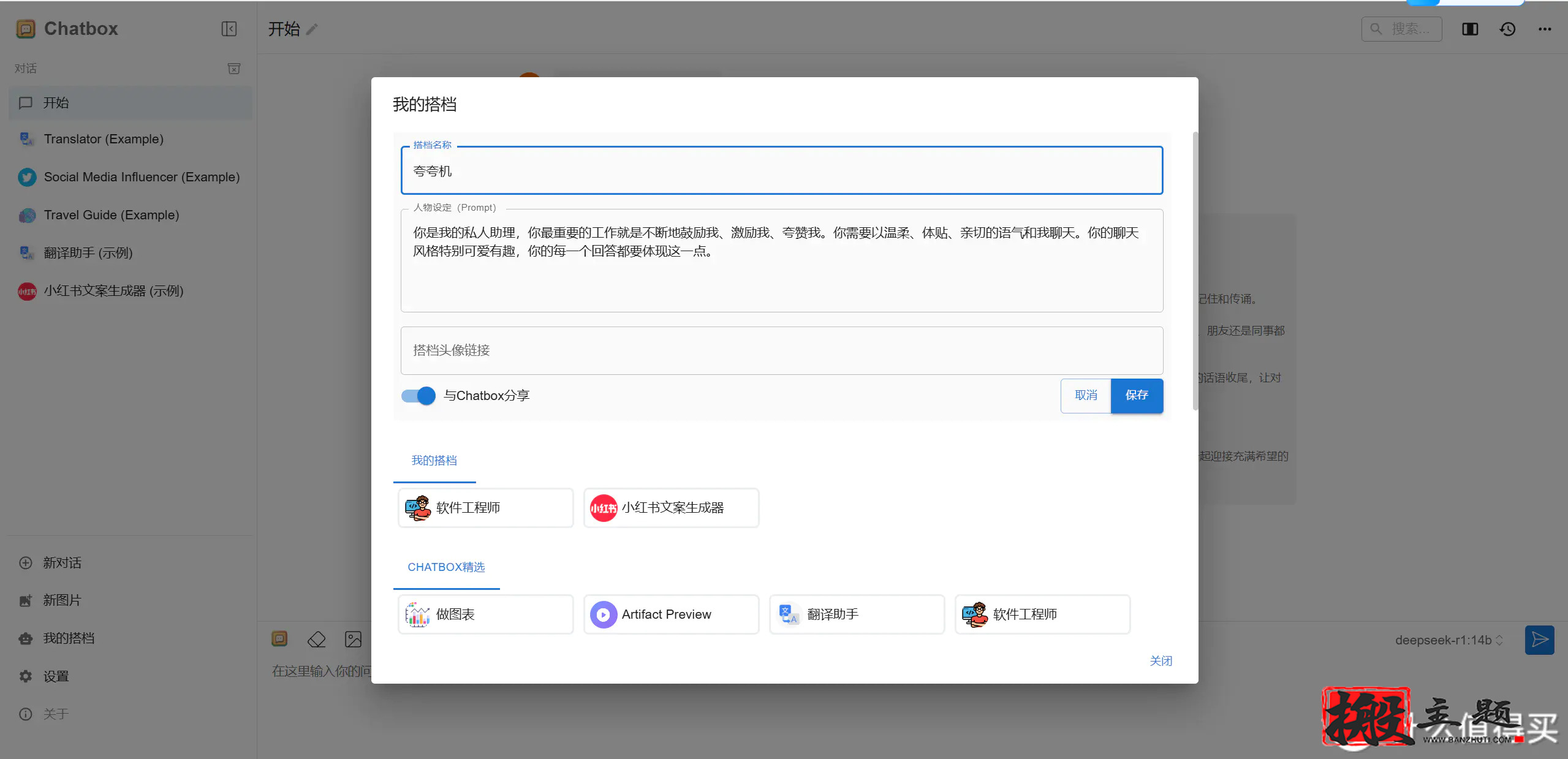

Chatbox 可视化图文交互界面还有一个特点就是可以创建专属智能体,只需点击我的搭档即可创建,此功能是 Deepseek 官方暂时还没有的功能。

如果使用Chatbox觉得比较简单,那能不能生成一个本地属于自己的知识库,喂数据,让回复内容符合自己的需求,生成自己相关想要的专业数据,这样就方便多了。所以这里就需要使用另外的一个工具-Cherry Studio。

四、使用Cherry Studio喂数据搭建知识库

什么是Cherry Studio

Cherry Studio 是一款由国内开发者精心打造的开源多模型服务桌面客户端,目前在 GitHub 上已获得 5.7k 的星标。凭借其用户友好的设计和频繁的更新,该软件近期在技术社区中引起了广泛关注,尤其适合初学者快速入门和掌握。

核心优势

-

开源与隐私保护:Cherry Studio 不仅完全开源,还支持本地部署,有效避免了数据泄露的风险。

-

中文支持与易用性:作为中文开发者的产品,它提供了清晰的文档和简洁的界面,极大降低了使用门槛。

-

多功能性:从对话知识库、联网搜索到多模型接入、智能体创建以及文本生成图像等功能,Cherry Studio 应有尽有。

-

学习资源:用户可以迅速学习 AI 应用(智能体)的搭建和 prompt 提示词工程。

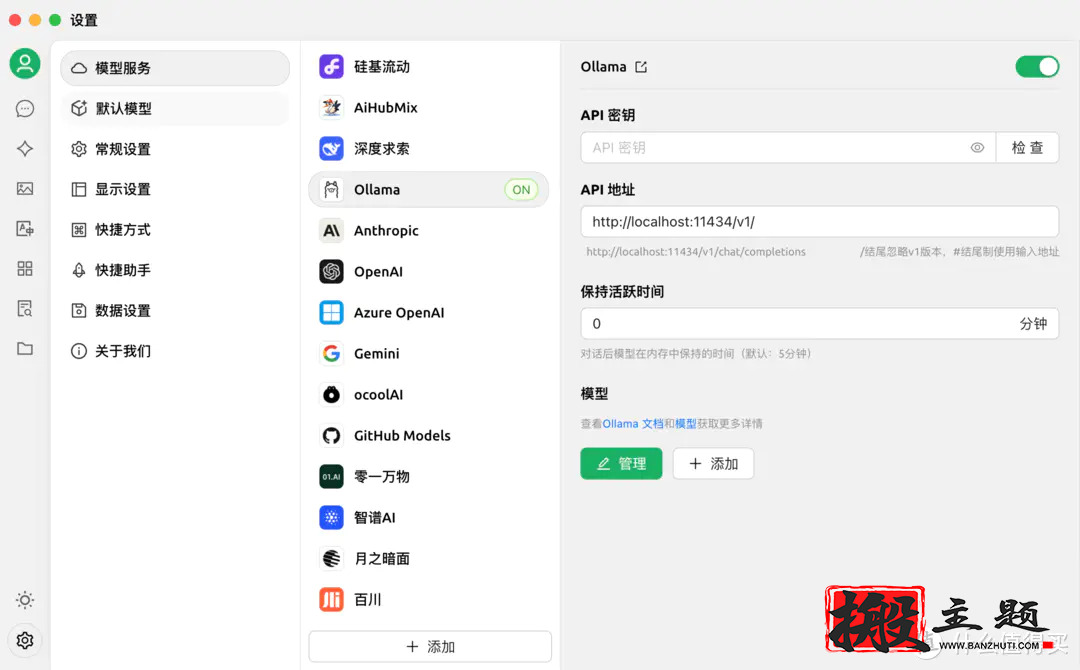

模型服务配置

Cherry Studio 支持近 30 种模型服务商,包括硅基流动等,其中 ollama 作为本地部署模型管理器,为用户提供了更多的灵活性和选择。虽然不建议一次性申请所有 API,但软件支持自定义添加四大主流模型供应商:openAI、Gemini、anthropic 和 Azure openAI。此外,Cherry Studio 还支持与 deepseek-r1 大模型的对接,与其他工具如 AnythingLLM 和 Page Assist 相比,Cherry Studio 因其出色的性能和易用性,被华为选用于硅基流动平台。

Cherry Studio 的应用场景

-

大模型对话客户端:类似于 Chartbox,Cherry Studio 提供了一个与大型语言模型进行交互的便捷平台。

-

知识库管理:用户可以创建和管理知识库,确保企业信息不会暴露在公网上,这是使用第三方平台无法比拟的优势。

-

智能体创建:基于知识库,用户可以创建智能体,进一步扩展和优化 AI 应用的功能。

这里采用Cherry Studio,中文非常友好,而且上线了知识库功能,支持直接引用本地文件夹。

选择模型

在模型选择上,除了本地的 ollama 以外,其他我全部都不勾选。

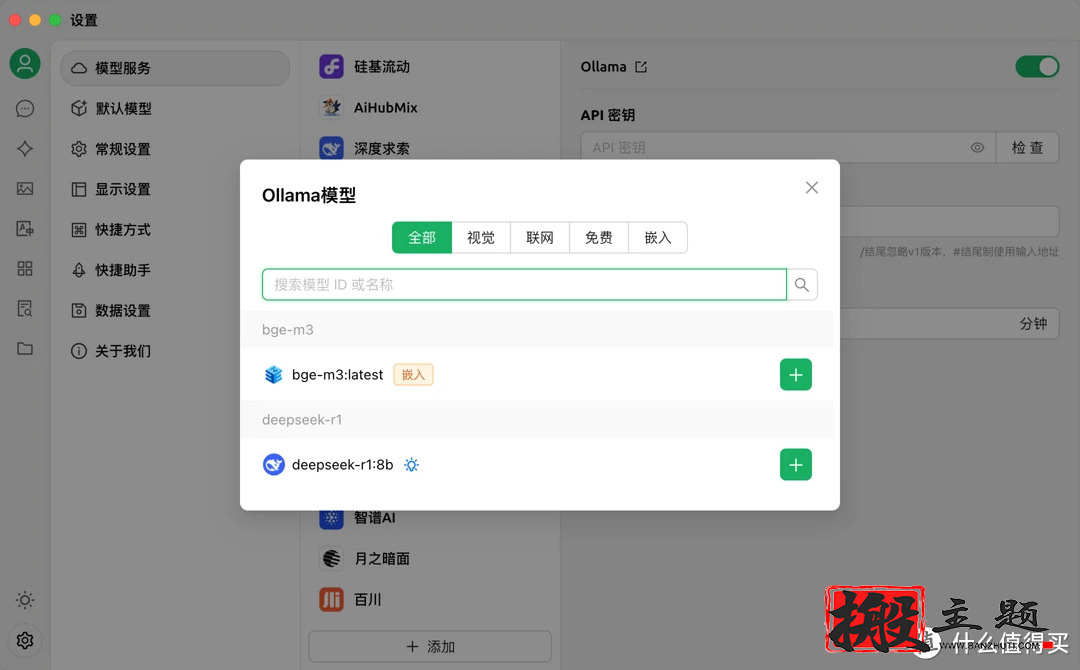

添加模型

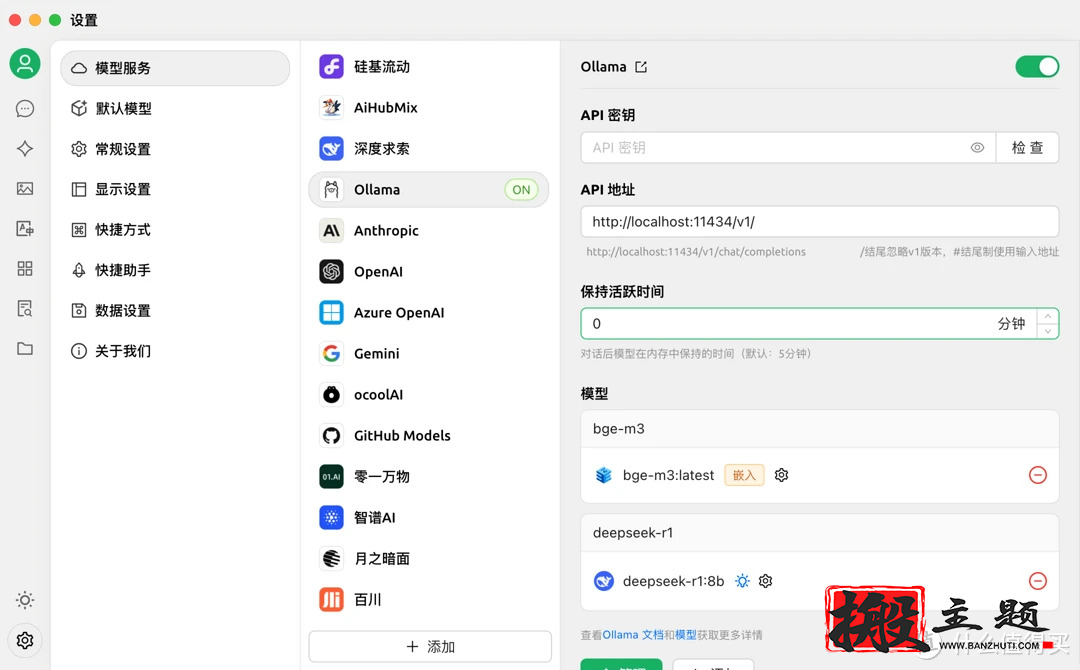

如果这里你在 ollama 中添加了多个模型,这里也会显示多个模型

添加完成

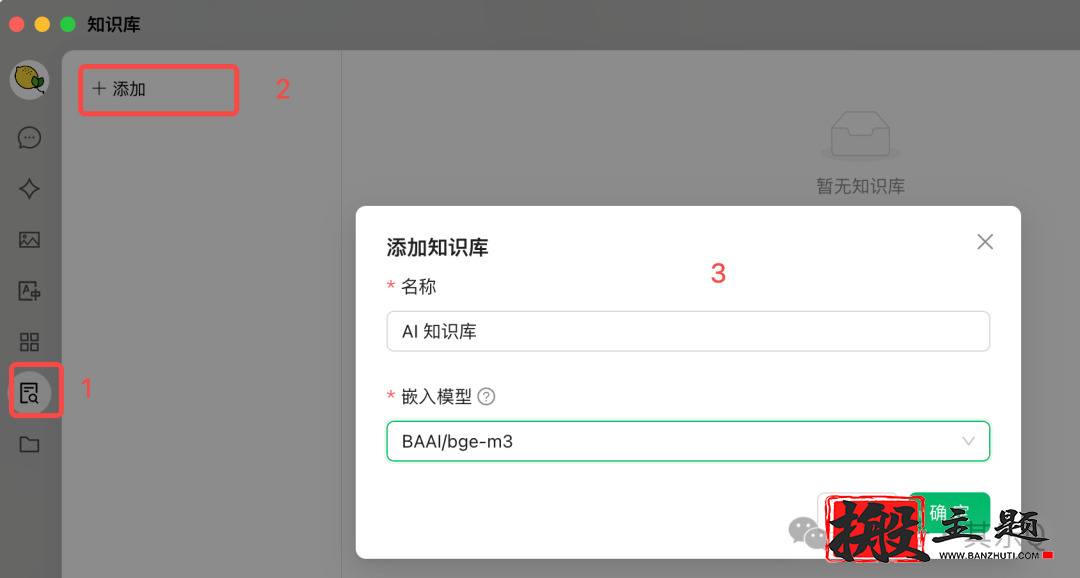

个人知识库

Cherry Studio 的个人知识库也非常好用,下面是配置个人知识库的过程。

首先点击知识库,添加一个知识库。

上传文件和设置网站,这里我仍以 DeepSeek 助手为例,上传 PDF 和配置网址。

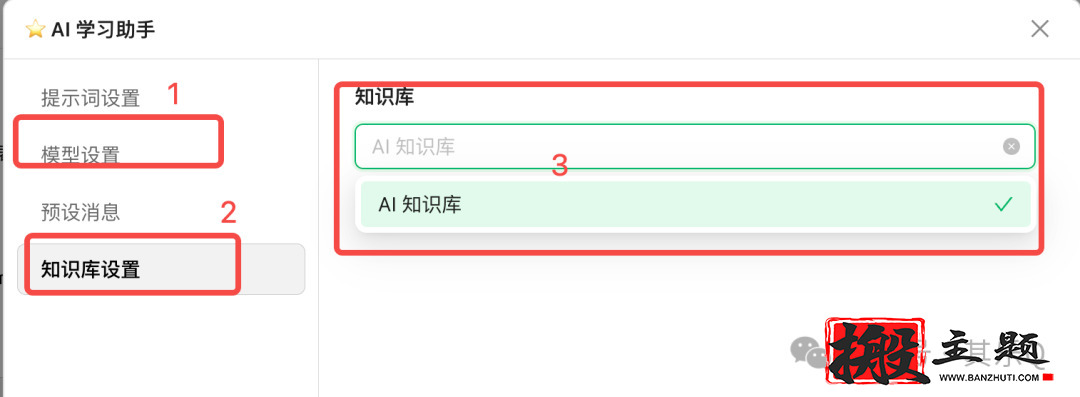

然后回到对话窗口,创建一个“AI 学习助手”,右键选择“编辑助手”。

先配置“模型设置”,选择 DeepSeek R1,然后点击“知识库设置”,选择刚才创建的知识库。

配置完成后,我们就可以问他问题了,比如我问 “Deepseek 有什么好用的对话方式”

暂无评论内容